Spark大型项目实战:电商用户行为分析大数据平台 视频教程 下载

课程介绍:

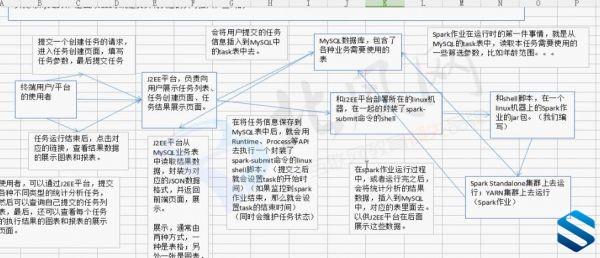

本项目主要用于互联网电商企业中,使用Spark技术开发的大数据统计分析平台,对电商网站的各种用户行为(访问行为、购物行为、广告点击行为等)进行复杂的分析。用统计分析出来的数据,辅助公司中的PM(产品经理)、数据分析师以及管理人员分析现有产品的情况,并根据用户行为分析结果持续改进产品的设计,以及调整公司的战略和业务。最终达到用大数据技术来帮助提升公司的业绩、营业额以及市场占有率的目标。

项目主要采用目前大数据领域最流行、最热门的技术——Spark,具有普通项目无法比拟的技术前瞻性与尖端性。本项目使用了Spark技术生态栈中最常用的三个技术框架,Spark Core、Spark SQL和Spark Streaming,进行离线计算和实时计算业务模块的开发。实现了包括用户访问session分析、页面单跳转化率统计、热门商品离线统计、广告流量实时统计4个业务模块。

项目中所有的业务功能模块都是直接从实际企业项目中抽取出来的,业务复杂度绝对没有任何缩水,只是为了更好的贴近大数据实战课程的需要,进行了一定程度上的技术整合和业务整合。该项目的真实性、业务复杂性以及实战型,绝对不是市面上现有的仅几个课时的Demo级的大数据项目可以比拟的。

通过合理的将实际业务模块进行技术整合与改造,该项目完全涵盖了Spark Core、Spark SQL和Spark Streaming这三个技术框架中,几乎所有的功能点、知识点以及性能优化点,仅一个项目,即可全面掌握Spark技术在实际项目中如何实现各种类型的业务需求!在项目中,重点讲解了实际企业项目中积累下来的宝贵的性能调优、troubleshooting以及数据倾斜等知识和技术,几乎所有知识和技术都是全网唯一,是任何其他视频课程以及书本中都没有包含的珍贵经验积累!同时以企业级大数据项目开发流程贯穿每个业务模块的讲解,涵盖了项目开发全流程,包括需求分析、方案设计、数据设计、编码实现、测试以及性能调优等环节,全面还原真实大数据项目的开发流程。该项目的整体商业价值绝对在百万元以上!

<第一章 大数据集群搭建>

│ │ ├1.1、课程介绍.mp4

│ │ ├1.10、实时数据采集流程介绍.mp4

│ │ ├1.11、Spark 1.5.1客户端安装以及基于YARN的提交模式.mp4

│ │ ├1.2、CentOS 6.4集群搭建-1.mp4

│ │ ├1.3、CentOS 6.4集群搭建-2.mp4

│ │ ├1.4、hadoop-2.5.0-cdh5.3.6集群搭建.mp4

│ │ ├1.5、hive-0.13.1-cdh5.3.6安装.mp4

│ │ ├1.6、zookeeper-3.4.5-cdh5.3.6集群搭建.mp4

│ │ ├1.7、kafka_2.9.2-0.8.1集群搭建.mp4

│ │ ├1.8、flume-ng-1.5.0-cdh5.3.6安装.mp4

│ │ └1.9、离线日志采集流程介绍.mp4

│ ├<第二章 用户访问session分析>

│ │ ├2.1、模块介绍.mp4

│ │ ├2.10、单例设计模式.mp4

│ │ ├2.11、内部类以及匿名内部类.mp4

│ │ ├2.12、开发JDBC辅助组件(上).mp4

│ │ ├2.13、开发JDBC辅助组件(下).mp4

│ │ ├2.14、JavaBean概念讲解.mp4

│ │ ├2.15、DAO模式讲解以及TaskDAO开发.mp4

│ │ ├2.16、工厂模式讲解以及DAOFactory开发.mp4

│ │ ├2.17、JSON数据格式讲解以及fastjson介绍.mp4

│ │ ├2.18、Spark上下文构建以及模拟数据生成.mp4

│ │ ├2.19、按session粒度进行数据聚合.mp4

│ │ ├2.2、基础数据结构以及大数据平台架构介绍.mp4

│ │ ├2.20、按筛选参数对session粒度聚合数据进行过滤.mp4

│ │ ├2.21、session聚合统计之自定义Accumulator.mp4

│ │ ├2.22、session聚合统计之重构实现思路与重构session聚合.mp4

│ │ ├2.23、session聚合统计之重构过滤进行统计.mp4

│ │ ├2.24、session聚合统计之计算统计结果并写入MySQL.mp4

│ │ ├2.25、session聚合统计之本地测试.mp4

│ │ ├2.26、session聚合统计之使用Scala实现自定义Accumulator.mp4

│ │ ├2.27、session随机抽取之实现思路分析.mp4

│ │ ├2.28、session随机抽取之计算每天每小时session数量.mp4

│ │ ├2.29、session随机抽取之按时间比例随机抽取算法实现.mp4

│ │ ├2.3、需求分析.mp4

│ │ ├2.30、session随机抽取之根据随机索引进行抽取.mp4

│ │ ├2.31、session随机抽取之获取抽取session的明细数据.mp4

│ │ ├2.32、session随机抽取之本地测试.mp4

│ │ ├2.33、top10热门品类之需求回顾以及实现思路分析.mp4

│ │ ├2.34、top10热门品类之获取session访问过的所有品类.mp4

│ │ ├2.35、top10热门品类之计算各品类点击、下单和支付的次数.mp4

│ │ ├2.36、top10热门品类之join品类与点击下单支付次数.mp4

│ │ ├2.37、top10热门品类之自定义二次排序key.mp4

│ │ ├2.38、top10热门品类之进行二次排序.mp4

│ │ ├2.39、top10热门品类之获取top10品类并写入MySQL.mp4

│ │ ├2.4、技术方案设计.mp4

│ │ ├2.40、top10热门品类之本地测试.mp4

│ │ ├2.41、top10热门品类之使用Scala实现二次排序.mp4

│ │ ├2.42、top10活跃session之开发准备以及top10品类RDD生成.mp4

│ │ ├2.43、top10活跃session之计算top10品类被各sessoin点击的次数.mp4

│ │ ├2.44、top10活跃session之分组取TopN算法获取top10活跃session.mp4

│ │ ├2.45、top10活跃session之本地测试以及阶段总结.mp4

│ │ ├2.5、数据表设计.mp4

│ │ ├2.6、Eclipse工程搭建以及工具类说明.mp4

│ │ ├2.7、开发配置管理组件.mp4

│ │ ├2.8、JDBC原理介绍以及增删改查示范.mp4

│ │ └2.9、数据库连接池原理.mp4

│ ├<第三章 企业级性能调优、troubleshooting经验与数据倾斜解决方案>

│ │ ├3.1、性能调优之在实际项目中分配更多资源.mp4

│ │ ├3.10、Shuffle调优之原理概述.mp4

│ │ ├3.11、Shuffle调优之合并map端输出文件.mp4

│ │ ├3.12、Shuffle调优之调节map端内存缓冲与reduce端内存占比.mp4

│ │ ├3.13、Shuffle调优之HashShuffleManager与SortShuffleManager.mp4

│ │ ├3.14、算子调优之MapPartitions提升Map类操作性能.mp4

│ │ ├3.15、算子调优之filter过后使用coalesce减少分区数量.mp4

│ │ ├3.16、算子调优之使用foreachPartition优化写数据库性能.mp4

│ │ ├3.17、算子调优之使用repartition解决Spark SQL低并行度的性能问.mp4

│ │ ├3.18、算子调优之reduceByKey本地聚合介绍.mp4

│ │ ├3.19、troubleshooting之控制shuffle reduce端缓冲大小以避免OOM.mp4

│ │ ├3.2、性能调优之在实际项目中调节并行度.mp4

│ │ ├3.20、troubleshooting之解决JVM GC导致的shuffle文件拉取失败.mp4

│ │ ├3.21、troubleshooting之解决YARN队列资源不足导致的application直接失败.mp4

│ │ ├3.22、troubleshooting之解决各种序列化导致的报错.mp4

│ │ ├3.23、troubleshooting之解决算子函数返回NULL导致的问题.mp4

│ │ ├3.24、troubleshooting之解决yarn-client模式导致的网卡流量激增问题.mp4

│ │ ├3.25、troubleshooting之解决yarn-cluster模式的JVM栈内存溢出问题.mp4

│ │ ├3.26、troubleshooting之错误的持久化方式以及checkpoint的使用.mp4

│ │ ├3.27、数据倾斜解决方案之原理以及现象分析.mp4

│ │ ├3.28、数据倾斜解决方案之聚合源数据以及过滤导致倾斜的key.mp4

│ │ ├3.29、数据倾斜解决方案之提高shuffle操作reduce并行度.mp4

│ │ ├3.3、性能调优之在实际项目中重构RDD架构以及RDD持久化.mp4

│ │ ├3.30、数据倾斜解决方案之使用随机key实现双重聚合.mp4

│ │ ├3.31、数据倾斜解决方案之将reduce join转换为map join.mp4

│ │ ├3.32、数据倾斜解决方案之sample采样倾斜key单独进行join.mp4

│ │ ├3.33、数据倾斜解决方案之使用随机数以及扩容表进行join.mp4

│ │ ├3.4、性能调优之在实际项目中广播大变量.mp4

│ │ ├3.5、性能调优之在实际项目中使用Kryo序列化.mp4

│ │ ├3.6、性能调优之在实际项目中使用fastutil优化数据格式.mp4

│ │ ├3.7、性能调优之在实际项目中调节数据本地化等待时长.mp4

│ │ ├3.8、JVM调优之原理概述以及降低cache操作的内存占比.mp4

│ │ └3.9、JVM调优之调节executor堆外内存与连接等待时长.mp4

│ ├<第四章 页面单跳转化率统计>

│ │ ├4.1、模块介绍.mp4

│ │ ├4.10、生产环境测试.mp4

│ │ ├4.2、需求分析、技术方案设计、数据表设计.mp4

│ │ ├4.3、编写基础代码.mp4

│ │ ├4.4、面切片生成以及页面流匹配算法实现.mp4

│ │ ├4.5、计算页面流起始页面的pv.mp4

│ │ ├4.6、计算页面切片的转化率.mp4

│ │ ├4.7、将页面切片转化率写入MySQL.mp4

│ │ ├4.8、本地测试.mp4

│ │ └4.9、生产环境测试.mp4

│ ├<第五章 各区域热门商品统计>

│ │ ├5.1、模块介绍.mp4

│ │ ├5.10、使用内置case when函数给各个区域打上级别标记.mp4

│ │ ├5.11、将结果数据写入MySQL中.mp4

│ │ ├5.12、Spark SQL数据倾斜解决方案.mp4

│ │ ├5.13、生产环境测试.mp4

│ │ ├5.2、需求分析、技术方案设计以及数据设计.mp4

│ │ ├5.3、查询用户指定日期范围内的点击行为数据.mp4

│ │ ├5.4、异构数据源之从MySQL中查询城市数据.mp4

│ │ ├5.5、关联城市信息以及RDD转换为DataFrame后注册临时表.mp4

│ │ ├5.6、开发自定义UDAF聚合函数之group_concat_distinct().mp4

│ │ ├5.7、查询各区域各商品的点击次数并拼接城市列表.mp4

│ │ ├5.8、关联商品信息并使用自定义get_json_object函数和内置if函数标记经营类型.mp4

│ │ └5.9、使用开窗函数统计各区域的top3热门商品.mp4

│ ├<第六章 广告点击流量实时统计>

│ │ ├6.1、需求分析、技术方案设计以及数据设计.mp4

│ │ ├6.10、对实时计算程序进行性能调优.mp4

│ │ ├6.11、生产环境测试.mp4

│ │ ├6.12、都学到了什么?.mp4

│ │ ├6.2、为动态黑名单实时计算每天各用户对各广告的点击次数.mp4

│ │ ├6.3、使用高性能方式将实时计算结果写入MySQL中.mp4

│ │ ├6.4、过滤出每个batch中的黑名单用户以生成动态黑名单.mp4

│ │ ├6.5、基于动态黑名单进行点击行为过滤.mp4

│ │ ├6.6、计算每天各省各城市各广告的点击量.mp4

│ │ ├6.7、计算每天各省的top3热门广告.mp4

│ │ ├6.8、计算每天各广告最近1小时滑动窗口内的点击趋势.mp4

│ │ └6.9、实现实时计算程序的HA高可用性.mp4